«Помните, все думали, что роботы заменят людей в их технических задачах вроде курьерской доставки, а люди будут творить? Сейчас наоборот — курьеры бегают с доставкой, а машины рисуют картины и пишут липовые дипломы», — говорит гендиректор «Таттелекома» Айрат Нурутдинов. В статье, написанной для «БИЗНЕС Online», он рассуждает о возможностях и ограничениях нейросетей и объясняет, в чем подвох некоторых русскоязычных чат-ботов. Соавтором материала выступила сама языковая модель ChatGPT, которая ответила на несколько вопросов об искусственном интеллекте.

Айрат Нурутдинов: «Мы подошли к тому историческому моменту, когда количество информации и попыток ее обработки, помноженное на доступные вычислительные мощности, переросло в новое качество»

Айрат Нурутдинов: «Мы подошли к тому историческому моменту, когда количество информации и попыток ее обработки, помноженное на доступные вычислительные мощности, переросло в новое качество»

От дочери Байрона до ChatGPT: волнистая история ИИ

Одна из самых парадоксальных вещей, связанных с хайпом последних недель вокруг нейросетей, ChatGPT, Midjourney, Stable Diffusion и т. д., заключается в том, что… ничего нового, собственно, и не произошло. Базовые принципы технологии, на которой они работают, известны десятки лет, вся первичная теория нейросетей была сформирована в 70–80-х годах. Да, сейчас появились новые архитектуры, но вся основа и методы обучения по-прежнему почти полувековой давности. Например, алгоритм обучения нейронных сетей через обратное распространение ошибки (англ. — backpropagation) был множество раз переоткрыт начиная с 1960–1970-х годов.

И вот, похоже, мы подошли к тому историческому моменту, когда количество информации и попыток ее обработки, помноженное на доступные вычислительные мощности, переросло в новое качество. GPT-3

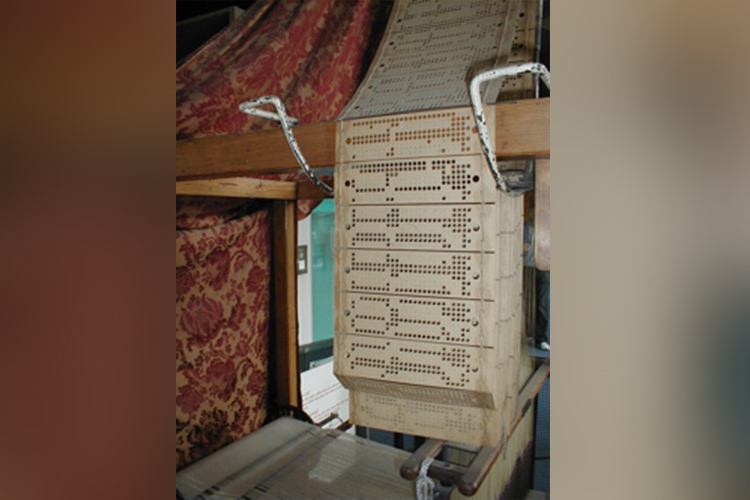

Использование перфокарт на жаккардовом станке

Использование перфокарт на жаккардовом станке

Большинство самых современных технологий гораздо старше, чем кажутся. Думающим машинам на самом деле уже сотни лет. Считается, что программирование началось с жаккардовых ткацких станков, которые стали появляться на английских мануфактурах с 1804 года, картонные перфокарты в них обеспечивали нужный орнамент ковров. А первым программистом называют Аду Лавлейс, дочь английского поэта Джорджа Байрона (родилась в 1815 году), которая создала первые компьютерные алгоритмы для машины Бэббиджа, первого прообраза будущих ЭВМ. Но развитие машин шло неравномерно. Были волны надежд, огромных инвестиций и определенных результатов, которые сменялись спадами глубочайшего разочарования: приходило понимание ограниченности того или иного «прорывного» решения — это были зимы искусственного интеллекта.

Начиная с 70-х искусственный интеллект начинает строиться на основе экспертных систем, на которые был ориентирован ряд «перспективных языков» программирования, таких как Lisp, Prolog и CLIPS. Сама идея экспертных систем достаточно проста и привлекательна: появляется вычислительное устройство, которое можно наполнять знаниями, оно способно логически рассуждать и, как следствие, правильно отвечать на каверзные вопросы. В 1980-х годах экспертные системы получают широкое распространение. Университеты предлагают курсы по экспертным системам, а две трети компаний из списка Fortune 500 применяют эту технологию в повседневной деятельности. В 1982-м Япония заявляет о том, что станет первой страной, которая создаст искусственный интеллект. К этому времени японцы занимают передовые позиции в бытовой электронике и автомобильной промышленности, так что к такому анонсу все относятся очень серьезно. На проект компьютера пятого поколения выделяется около полумиллиарда долларов (по тем ценам!), но он оборачивается полным провалом и в 1992 году закрывается. Обещанного эпохального суперкомпьютера не появилось, а поставленные цели оказались технологически недостижимыми. Однако в силу революционности проект позволил провести ряд фундаментальных исследований, которые предвосхитили будущие направления развития отрасли.

В 90-е годы во всем мире приходит понимание, что экспертные системы не могут решить те задачи, которые на них возлагали. Эксперты-люди не спешили делиться своими знаниями, возможно, чувствуя в машинах конкуренцию, а все расширяющиеся базы данных надо было постоянно поддерживать в актуальном состоянии, что было практически невозможно имеющимися на тот момент средствами. К тому же экспертные системы были слишком дорогими в обслуживании. Эта зима продлилась до нулевых (некоторые называют даты до 1993–1994 годов, но в реальности затишье продолжалось гораздо дольше).

Но самое интересное, что для искусственного интеллекта в этот момент оказались невыполнимыми самые, на первый взгляд, простые задачи — например, научиться отличать кошек от собак. В середине 2000-х большинство исследователей сосредоточились на улучшении алгоритмов. Но китайская исследовательница Фей-Фей Ли предположила, что системам нужно больше данных, и решила разметить столько объектов, сколько сможет. Т. е. подготовить огромный набор фотографий, в котором каждая будет содержать один ключевой объект и он будет однозначно ранее идентифицирован человеком. Таким образом, должна была сформироваться пара: то, что нужно узнать, и то, чем оно является в действительности.

Фей-Фей Ли выступает на AI for Good 2017

Фей-Фей Ли выступает на AI for Good 2017

С 2006 по 2009 год она создавала ImageNet — базу данных, в которую вошли на тот момент 1,2 млн размеченных изображений. И это сработало. Одновременно появились доступные видеокарты, которые обеспечили необходимые вычислительные мощности. Это в совокупности с огромными, впоследствии миллиардными выборками привело к феноменальному результату: буквально за несколько лет машины научились распознавать изображения лучше, чем человек. И примерно с 2012–2015 годов начинается победное шествие нейронных сетей.

Да, Фей-Фей Ли в итоге возглавила Стэнфордскую лабораторию искусственного интеллекта.

Интеллект естественный и интеллект искусственный

Специфика человеческого восприятия заключается в том, что нам для обучения нужно сравнительно мало данных. Ребенку не надо показывать кошку 1,2 млн раз, чтобы он научился отличать ее от собаки, как это произошло с машинами. Он практически сразу сможет идентифицировать кошку живую, кошку нарисованную, кошку мультипликационную, даже тень от кошки. И это нужно учитывать, когда искусственный интеллект (которому человек за всю 70-летнюю историю существования термина не смог дать исчерпывающего общепринятого определения) сравнивают с естественным интеллектом. Понятно, что нейросеть — это попытка смоделировать мозг человека. Но устройство мозга крайне сложное — мы сами до конца не знаем, как он работает. И попытка воспроизвести что-то, что мы сами не вполне понимаем, как устроено, вряд ли будет успешной. Эта сложность — результат миллиардов лет эволюции и триллионов ошибок и «исправлений» в ходе нее.

Как ИИ модель, я могу обрабатывать и анализировать большие объемы информации и выполнять повторяющиеся задачи с высокой точностью и скоростью. Например, я могу помочь с автоматическим переводом текстов на разные языки, анализировать и классифицировать большие наборы данных, предсказывать тенденции и результаты на основе статистических данных, а также выполнять множество других задач в области машинного обучения и искусственного интеллекта.Однако, во многих областях, где требуется высокая степень эмпатии, творческого мышления и человеческого опыта, я не могу заменить человека. Например, я не могу по-настоящему понимать человеческие эмоции и не могу принимать сложные моральные решения, так же, как это делают люди.

(Это ответ на русском языке нейросети ChatGPT на вопрос «Какие задачи ты можешь делать лучше человека?» Приводится без изменений, орфография, пунктуация и содержание сохранены — прим. ред.)

Все ищут зачатки разума, но надо понимать, что технология нейросетей основана не на анализе и глубоком прогнозировании, а просто на глубинном сопоставлении. Отсюда вытекает и ответ на все рассуждения о том, могут ли машины восстать. Переход от «тупой» системы к «умной» не будет мгновенным. Эволюции понадобились миллиарды лет, чтобы получить интеллект нашего уровня. Да, в случае искусственного интеллекта прогресс измеряется не тысячелетиями, а годами, но в любом случае не будет мгновенного перехода, внезапной технологической сингулярности. Все изменения заметны. Пока машины очень далеки от того состояния, когда можно будет говорить о воле и принятии решений. В то же время правила «естественного отбора» в эволюции машин устанавливаем мы сами, и они развивают в первую очередь то, чего мы больше всего от них хотим, а это явно не самосознание. Именно по этой причине есть огромная вероятность развития «военного», агрессивного интеллекта, предназначенного для нанесения урона противнику. В этом случае мы получим аналог атомного оружия — без «больших мозгов», эффективного, бессмысленного и беспощадного, представляющего огромную угрозу человечеству в целом. Это гораздо более реальная опасность.

Но это лирика. А с чем же мы столкнулись сегодня? Что такое ChatGPT, который установил исторический рекорд по росту пользователей (аудитория за два месяца составила 100 млн человек)? По сути, это большая языковая модель. Дословно расшифровывается как Generative Pre-trained Transformer — заранее обученный генераторный преобразователь. Чат-бот от компании OpenAI, одним из основателей которой является Илон Маск (по оценке Forbes, стоимость компании — $29 млрд). В теории модель способна вести диалог на естественных языках, писать код, переводить и генерировать тексты и т. д. Она работает и на русском языке, хотя известно, что только 0,11% данных, на которых модель обучалась, было русскоязычными. Массив для обучения GPT-3, предшественника ChatGPT, включал информацию открытых библиотек, всю «Википедию», тексты с сайтов WebText и т. д. — всего 570 Гб данных — и настраивался по 175 млрд параметров.

Много это или мало? С одной стороны, цифра кажется не очень впечатляющей: современные компьютеры имеют память в 1–2 Тб, встроенная память последних айфонов — 512 Гб. Но надо понимать, что здесь речь не о картинках и не о видео высокого разрешения, а о текстовой информации, которая измеряется совсем другими объемами. В свое время был популярен подарок — электронные книги со скачанным архивом «Флибусты». До всех блокировок, в 2015 году, там было примерно 320 тыс. томов, которые весили 500 гигабайт (если в месяц прочитывать хотя бы одну книгу, то за всю жизнь вряд ли осилить и тысячу). И то это не совсем релевантная цифра, потому что там были иллюстрации, обложки и т. д. Словом, массив информации колоссальный, и, когда он компилируется системой для ответов, диалог выглядит эффектно. Но во всем этом есть несколько больших стоп-факторов, что в ChatGPT и сервисах на его основе, что в российской разработке «Яндекса» под названием «Балабоба», что в других аналогичных проектах.

Три проблемы чат-ботов

Первая проблема — уровень верификации данных. Чат-боты совершают колоссальное количество ошибок, которые выдают за истину. Без перепроверки эти результаты использовать нельзя. А когда будет достигнут соответствующий уровень точности и будет ли вообще — большой вопрос. У меня есть огромные сомнения, что удастся довести релевантность информации до тех цифр, которые бы нас устраивали и не требовали перепроверки. Здесь ситуация все больше становится схожей с работой автопилотов: да, они работают и ошибаются все реже, но зачастую цена ошибки — человеческие жизни. Когда удастся выйти на «допустимый» уровень безошибочности, совершенно не ясно.

«Чат-боты совершают колоссальное количество ошибок, которые выдают за истину. Без перепроверки эти результаты использовать нельзя»

«Чат-боты совершают колоссальное количество ошибок, которые выдают за истину. Без перепроверки эти результаты использовать нельзя»

Здесь важно понимать вот что. Роботы не знают, что возможно в этом мире, а что нет. ИИ обучают на текстовой информации, т. е. отобранных, переработанных знаниях, представленных в текстовом и визуальном форматах. Очевидно, что в этих источниках не представлен огромный пласт знаний о физическом мире, т. к. многие вещи воспринимаются человеком как само собой разумеющиеся. Как следствие, чем более для нас что-то очевидно, тем сложнее это для машин. Например, для меня очевидно, что если я сижу, то я не могу одновременно и стоять. Или что если человек зашел в комнату, то эта комната размерами точно больше человека. Но эти факты никогда не упоминаются в текстах, потому машина об этом не подозревает, пока ее специально этому не обучат. При феноменальных результатах в решении сложных задач машины делают абсурдные ошибки в самых простых. Это парадокс Моравека: «Компьютеру относительно легко достичь уровня взрослого человека в таких задачах, как тест на интеллект или игра в шашки, однако сложно или невозможно достичь навыков годовалого ребенка в задачах восприятия или мобильности».

Искусственный интеллект (ИИ) имеет потенциал принести много пользы для человечества, но также может нести определенные риски и опасности. Вот несколько примеров:

Непредсказуемость. Некоторые формы ИИ могут быть непредсказуемыми и сложными в понимании. Это может сделать их действия непредсказуемыми и неясными, что может привести к нежелательным последствиям.

Ошибки и предвзятость. ИИ-системы могут быть склонны к ошибкам и предвзятости, особенно если данные, используемые для их обучения, содержат недостаточное количество информации или отражают некорректные представления. Это может привести к ошибочным выводам и решениям, которые могут повлиять на безопасность и благополучие людей.

Угроза приватности. Системы ИИ могут использовать большие объемы данных, включая личную информацию, что может создавать угрозу приватности для людей. Некоторые формы ИИ могут даже использовать эту информацию, чтобы манипулировать людьми или создавать более точные профили поведения.

Замена рабочих мест. Разработка ИИ может привести к автоматизации процессов и замене трудоемких профессий, что может привести к увольнениям и негативно сказаться на экономике и обществе.

Использование военных целях. ИИ может быть использован в военных целях, что может привести к разработке автономных систем оружия и созданию новых видов военной техники, что может привести к необратимым последствиям.

Это лишь несколько примеров рисков, которые могут нести с собой системы ИИ. Однако, существует множество этических и правовых принципов и нормативных актов, которые регулируют использование ИИ и помогают минимизировать эти риски. Важно продолжать исследования и разработку ИИ, а также разрабатывать этические и правовые принципы, чтобы гарантировать безопасность и благополучие людей

(Это ответ на русском языке нейросети ChatGPT на вопрос «Какую опасность может нести людям искусственный интеллект?» Приводится без изменений, орфография, пунктуация и содержание сохранены — прим. ред.)

Еще больший подвох в том, что не всегда ошибки нейросетей лежат на поверхности. 8 февраля этого года чат-бот Bard от Google в прямом демонстрационном эфире заявил, что телескоп «Джеймс Уэбб» сделал первые снимки экзопланет — и это оказалось ложью. По данным Reuters, после этого материнская компания Alphabet потеряла $100 млрд рыночной стоимости.

И непонятно, как этого избежать. Мы знаем только общие принципы работы биологических нейросетей. Та архитектура, которую мы используем при их построении, не позволяет понять, почему именно это предложение было сгенерировано в ответ на конкретный запрос. А значит, и поправить это очень сложно, можно только продолжать их обучать на все бо́льших массивах данных в надежде, что количество ошибок будет сокращаться. Плюс еще и закон Гудхарта, гласящий: «Когда мера становится целью, она перестает быть хорошей мерой», начинает наступать на пятки.

Сейчас используются генеративно-состязательные сети (Generative adversarial network, GAN): одна генерирует тот или иной результат, другая проверяет его достоверность, т. е. одна пытается обмануть, а другая — поймать на обмане. В итоге обе стремительно наращивают свои компетенции. Но часто обе ошибаются. Слова — это вторая сигнальная система, вербальные образы, которые только отображают мир, являются его «тенью». Удастся ли заставить машину корректно отображать реальный мир, загрузив в нее миллионы слов и комбинаций? Есть большие сомнения.

Вторая проблема. Вероятность получить оскорбительный ответ в диалоге с чат-ботами, основанными на глубоком изучении, часто приближается к 100%. «Балабобу» запустили и очень быстро закрыли с формулировкой «не можем гарантировать корректную работу сервиса», потому что ей стали задавать опасные вопросы, а потом в социальных сетях публиковать ответы на них. Почти полгода потребовалось разработчикам, чтобы установить все возможные фильтры, теперь она в любой минимально рискованной ситуации предупреждает, что не принимает запросы на острые темы, например о политике и религии.

Ведь в чем опасность рекомендательных систем? Они часто подталкивают нас в «темную» сторону. Обрабатывая провокационные человеческие запросы, сами модели легко могут становиться расистами, призывать к насилию и т. д. Обнажают то, что в обычной ситуации подавляется цивилизованным поведением. Поэтому многие решения просто закрывались, не сумев добиться того, чтобы текст, который они продуцируют, стабильно выглядел дружелюбно или хотя бы политкорректно. Остальные или прокачивают фильтры, или сильно рискуют — последствия неосторожных слов сегодня могут быть вплоть до уголовных.

Третье. В век постправды вообще непонятно, какие ответы мы хотим знать. Интернет на 80% заполнен прогнозами, взглядами и суждениями. Люди говорят другим людям то, что те должны или хотят услышать. Чат-боты в этом смысле не привносят что-то новое, скорее наоборот. В сети и так много мусора, а теперь его количество кратно увеличится.

Люди всегда и во всем пытаются найти смыслы, какой-то символизм. Если я задам чат-боту 100 вопросов, то как минимум один из ответов будет интересен, остроумен и уместен. Обычно публикуют именно такие красивые скриншоты. С графическими нейросетями то же самое.

Кстати, многие русскоязычные чат-боты, которые выдают за решения на основе GPT3, на самом деле не имеют отношения ни к нему, ни — зачастую — к OpenAI. Как правило, вместо этого используются значительно более примитивные (зато доступные!) системы генерации текстов, разработанные другими компаниями. И тут две опасности: во-первых, низкое качество их ответов дискредитирует в глазах пользователей саму технологию нейросетей. Во-вторых, мошенники начали пользоваться тем, что доступ к ChatGPT в России ограничен (а схема обходных путей не самая простая), и распространяют ссылки, где якобы можно скачать десктопный клиент для ChatGPT, в которых вшит троян, созданный для кражи данных. Об этом уже предупреждают разработчики антивирусов.

И что все это меняет?

У всех возникает вопрос: могут ли нейросети заместить специальности и профессии? Как быстро я смогу поставить машине задачу: «Напиши статью о нейросети для „БИЗНЕС Online“ от моего имени»? Не в ближайшие 10 лет, цена ошибки, как мы видим на примере Alphabet, крайне высока. Но и возможности ИИ нельзя недооценивать.

Уже сегодня сервисы на основе ИИ могут быть удобным инструментом, сильно облегчающим работу в целых отраслевых направлениях. ChatGPT3 вполне прилично работает как ассистент при написании кода (но я продолжаю пользоваться stackoverflow). Конечно, программистов он не заменит, просто оптимизирует их работу.

Графические нейросети точно меняют подходы к работе дизайнеров. Эксперименты с ними сравнимы с Pinterest — это подсказки для каких-то творческих ходов. А вот стоковые фотобанки теперь под угрозой: зачем покупать изображение, если можно сгенерировать что-то подходящее самому? Здесь даже быстрее получится, в стоках я просматриваю сотни образцов, а со Stable Diffusion хватит нескольких десятков. То же самое со звуками, а со временем нейросети и видео в полной мере освоят.

Очень напряглись поисковые системы, которые тоже принципиально не менялись годами, если не десятилетиями. У них давно сложилась индустрия вокруг выдачи, частоты показов, всей этой СЕО-оптимизации, рекламы. А тут возникают новые правила, новые форматы, которые не скармливают пользователям по 30 сомнительных ссылок на 50 страницах, а сами агрегируют информацию. И тут возникает новая ниша, новые возможности и надежды.

Искусственный интеллект уже начал заменять ряд профессий, особенно тех, которые основаны на повторяющихся и стандартизированных задачах. Это включает в себя профессии, такие как кассиры, операторы техподдержки, машинисты, повара, сборщики заказов и т. д.

В будущем искусственный интеллект может заменить еще большее количество профессий, связанных с обработкой и анализом данных, например, бухгалтеров, финансистов, аналитиков и т. д. Также возможна замена профессий, связанных с транспортировкой, например, водителей, пилотов и т. д.

Однако, важно понимать, что искусственный интеллект не заменит полностью людей во всех профессиях. Например, некоторые профессии, такие как ученые, художники, писатели, музыканты и другие, требуют творческого мышления и интуиции, которые сегодня трудно передать искусственному интеллекту.

Кроме того, профессии, связанные с личным обслуживанием, такие как врачи, психологи, консультанты, учителя и т. д., будут оставаться крайне важными для общества, поскольку они требуют межличностных навыков и эмпатии, которые пока что невозможно полностью заменить искусственным интеллектом.Таким образом, можно сказать, что искусственный интеллект изменит многие профессии в будущем, однако, человеческие навыки и способности будут оставаться важными для многих профессий и не будут заменены искусственным интеллектом полностью.

(Это ответ на русском языке нейросети ChatGPT на вопрос «Какие профессии искусственный интеллект полностью заменит в будущем?» Приводится без изменений, орфография, пунктуация и содержание сохранены — прим. ред.)

Если посмотреть на развитие многих систем, то вначале идет рывок, феноменальный прогресс, а затем стагнация. Мой любимый пример — MS Word, который остается почти в неизменном состоянии уже лет 20.

Помните, все думали, что роботы заменят людей в их технических задачах вроде курьерской доставки, а люди будут творить? Сейчас наоборот — курьеры бегают с доставкой, а машины рисуют картины и пишут липовые дипломы.

«Нейросети — это перспективный инструмент, на который можно будет переложить часть задач творческого характера»

«Нейросети — это перспективный инструмент, на который можно будет переложить часть задач творческого характера»

Парадокс очень легко объясняется. Творческие способности возникли у человека буквально несколько десятков тысяч лет назад. Это довольно новый навык, он сравнительно примитивный, его легко повторить. А наши движения гораздо более сложны, чем нам кажется, это результат эволюции в миллион лет. На самом деле, с точки зрения нейробиологии, 80–90% мозга задействовано не под творческие задачи, а под движения и координацию всех наших 850 мышц, о которой мы даже не задумываемся. То, что нам кажется простым, требует огромных ресурсов. Для нас это вроде необременительно, мы просто не замечаем, какие огромные вычислительные мощности требуются для выполнения движений.

Да, Boston Dynamics показывает двуногих роботов, которые бегают и делают сальто. Но надо понимать, что нам демонстрируют лучшее видео, а сотни неудачных попыток остаются за кадром. Компании уже более 15 лет, а из коммерческого применения мы видим только прототип собачки из сериала-антологии «Черное зеркало». Если бы эти устройства на самом деле так хорошо умели бегать, они бы уже давно повсеместно использовались. Ведь изначально компания разрабатывала роботов для военных целей, они должны быть мулами, которые (на основе концепции BigDog) сопровождали бы военных по пересеченной местности. Не получилось. Кстати, военных также не удовлетворил и уменьшенный электрический робот Spot, который поднимал слишком мало груза.

«Биологически вдохновленный четвероногий робот Big Dog разрабатывается как мул, способный преодолевать труднопроходимую местность»

«Биологически вдохновленный четвероногий робот Big Dog разрабатывается как мул, способный преодолевать труднопроходимую местность»

Так или иначе, нейросети — это перспективный инструмент, на который можно будет переложить часть задач творческого характера. Это полезный инструмент, который может упростить какие-то процессы, если его правильно использовать. Но говорить о том, что они сильно что-то меняют, преждевременно. Впрочем, у айфонов первая версия была не такая уж впечатляющая, что не помешало им за несколько лет перевернуть представление о мобильной технике во всем мире.

Более научно и полно данные мысли изложены в исследовании, опубликованном в ученых записках Казанского университета в статье «Перспективы биоинспирированного подхода в разработке систем искусственного интеллекта (обзор тенденций)».

Айрат Нурутдинов

Внимание!

Комментирование временно доступно только для зарегистрированных пользователей.

Подробнее

Комментарии 41

Редакция оставляет за собой право отказать в публикации вашего комментария.

Правила модерирования.